Python爬蟲動態負載均衡技術如何徹底改變數據抓取?

隨著網路數據的瘋狂增長,爬蟲技術的重要性日益增加。而在這些技術中,動態負載均衡成為了確保爬蟲程序高效運行的關鍵。本文將深入探討如何利用Python的強大功能,尤其是requests庫,來實現一個優雅的負載均衡系統,並確保數據抓取的高效性與可靠性。

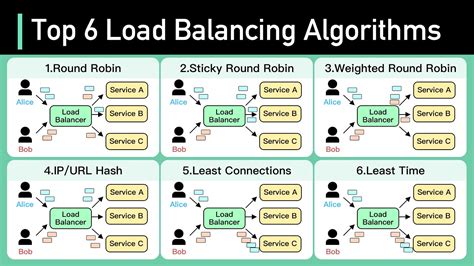

什麼是負載均衡?

負載均衡,顧名思義,就是將工作負載合理分配到多個系統資源上,以確保每個資源都能高效地運行。特別是在分布式系統中,負載均衡能夠顯著提升系統的性能和穩定性。當我們談論爬蟲時,負載均衡意味著將網頁抓取任務合理分配到多個爬蟲節點上,以避免單一節點過載。

如何在分布式爬蟲中實現負載均衡?

在Python中,我們可以利用requests庫來發送HTTP請求,並通過爬蟲IP參數設置爬蟲IP伺服器。這裡有一個關鍵步驟,就是維護一個爬蟲IP伺服器列表,這樣在每次發送請求時,可以從列表中選擇一個IP來使用,以達到負載均衡的效果。

爬蟲池與URL隊列

簡單來說,我們需要維護兩個主要的結構:

- 爬蟲池:這是一組可以用來發送請求的IP地址。

- URL隊列:待抓取的網頁地址。

在每次發送請求時,我們從URL隊列中選取一個URL,然後從爬蟲池中選擇一個IP來執行抓取任務。這樣的設計確保了負載在不同的IP之間合理分配,避免了單一IP的過載問題。

使用Splash進行大規模抓取

當面對極大量的爬取任務時,單單依靠一個Splash服務來處理是遠遠不夠的。這時,搭建一個負載均衡器來將壓力分散到多個Splash服務上,將變得至關重要。這樣的架構不僅能夠更高效地處理大量請求,還能增加系統的可靠性。

數據一致性與故障恢復策略

在分布式環境中,數據一致性和故障恢復是兩個不可忽視的問題。爬蟲程序需要確保每次抓取到的數據都是最新的,這就需要有良好的數據一致性策略。此外,當某個爬蟲節點出現故障時,我們需要有相應的恢復策略,確保系統能夠盡快恢復正常運行。

數據一致性

實現數據一致性的一種常見方法是使用分布式鎖技術來保證同一時間只有一個節點對數據進行修改。這樣可以避免數據競爭和不一致的情況發生。

故障恢復

故障恢復策略的核心在於系統的冗餘設計。通過在系統中引入冗餘節點,當某個節點發生故障時,可以迅速切換到備用節點,以最小化服務中斷時間。

爬蟲與動態內容

現代網頁越來越多地使用JavaScript來動態生成內容,這給爬蟲帶來了新的挑戰。為了爬取這些動態內容,爬蟲需要具備處理JavaScript的能力。

使用Splash處理動態內容

Splash是一個專為處理JavaScript而設計的渲染服務。通過將Splash整合到爬蟲系統中,我們可以輕鬆地抓取那些使用JavaScript生成的動態內容。

表格:常用爬蟲工具比較

下表列出了一些常用的Python爬蟲工具及其特點:

| 工具名稱 | 特點 | 連結 |

|---|---|---|

| Requests | 簡單易用的HTTP庫,適合基本的數據抓取 | Requests |

| Urllib | 標準庫的一部分,支持基本的HTTP操作 | Urllib |

| Splash | 能夠渲染JavaScript的HTTP API,適合動態頁面 | Splash |

| Scrapy | 強大的爬蟲框架,適合大規模數據抓取 | Scrapy |

常見問題

什麼是robots協議?

robots協議是網站用來告訴爬蟲哪些頁面可以抓取,哪些不可以的協議。遵循這個協議有助於避免法律和倫理問題。

如何處理網站的驗證碼?

處理驗證碼是一個複雜的問題。目前常用的方法包括使用第三方服務進行自動化處理,或是人工干預。

有哪些常見的數據解析方式?

常見的數據解析方式包括正則表達式、BeautifulSoup、lxml等,這些工具能夠幫助我們從HTML中提取出所需的數據。

如何抓取動態生成的內容?

可以使用Splash或Selenium等工具來處理和抓取由JavaScript動態生成的內容。

爬蟲如何實現動態負載均衡?

可以通過維護一個IP池,使用隨機或循環的方式選擇IP來發送請求,從而實現動態負載均衡。

在分布式環境中如何保證數據一致性?

可以使用分布式鎖、版本控制等技術來確保數據的一致性。

結論

Python的爬蟲技術在動態負載均衡的助力下,已經成為數據抓取領域無可取代的利器。通過合理的架構設計和工具選擇,我們可以輕鬆應對大規模的數據抓取需求,並確保系統的高效性和可靠性。掌握這些技術,不僅能夠提升抓取效率,還能夠確保數據的一致性和完整性,這對任何需要大量數據分析的領域都是至關重要的。