Python爬蟲軟體架構設計的秘密大公開!

在這個數位化的時代,數據已成為新時代的石油,而網路爬蟲則是挖掘這座資料寶藏的利器。想像一下,透過一個小小的程式,我們就能從網絡中擷取大量的資訊,這不禁讓人感到興奮!今天,我們要來揭開如何利用Python設計一個高效能的爬蟲軟體架構的秘密,讓你也能成為數位世界的探險家。

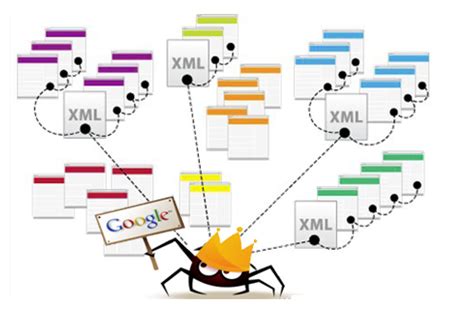

什麼是分布式爬蟲?

在開始之前,我們先來理解一下"分布式爬蟲"是什麼。分布式爬蟲是一種將爬取任務分散到多個節點(計算機)上的架構,每個節點獨立工作並互相協作,為了共同完成大規模數據的擷取任務。這個概念就像是多個小精靈在協力合作,互相傳遞消息,共同完成一項巨大的工程。

分布式爬蟲與簡單爬蟲的差異是什麼?

分布式爬蟲與簡單爬蟲最大的差異就在於規模與效率。簡單爬蟲通常是在單一計算機上運行,適合小規模的數據擷取;而分布式爬蟲則透過多台計算機的協作,大大提升了數據擷取的速度和容量。這就像是一人搬家與多人團隊合作搬家的差別,效率不言而喻。

如何開始設計你的爬蟲架構?

設計一個高效能的爬蟲架構並不是一件容易的事,但只要掌握了一些關鍵概念與技術,你也能輕鬆上手。以下是一些在設計爬蟲時的重要考量。

網頁訪問的模擬

爬蟲的基本概念就是模擬人類瀏覽網頁的行為,這包括了上下滾動頁面、登入、點選等動作。透過這些行為的模擬,爬蟲可以自動化地從網頁擷取所需的資訊。這個過程中,Python的套件如Selenium、BeautifulSoup等便派上了用場。

中間件的功能解析

在爬蟲架構中,中間件的角色非常重要。中間件主要用於處理請求與響應,這裡面包括了資料的過濾、解析、儲存等功能。透過合理的中間件設計,可以大大提高爬蟲運行的效率和穩定性。

使用Python套件提升爬蟲效能!

Python擁有豐富的套件資源,這些資源能夠大大提升爬蟲的效能與便利性。

重要的Python套件有哪些?

- Pandas:主要用於資料的分析與處理,它能夠輕鬆地將擷取到的資料進行格式化與清理。

- Numpy:這是一個用於大量數值計算的套件,對於需要進行數據分析的爬蟲專案來說,Numpy是不可或缺的工具。

- Scrapy:這是一個專業的爬蟲框架,能夠快速構建和部署爬蟲專案。

分布式爬蟲的實現步驟

設計一個分布式爬蟲需要考量到多個方面,包括節點的溝通、任務的分配與協作等等。以下是實現分布式爬蟲的一些步驟:

- 節點設置:確保每個節點能夠獨立運行,並擁有相應的計算資源。

- 資料庫配置:使用一個集中式的資料庫來存儲爬取到的數據,這樣可以確保數據的一致性。

- 任務分配:設計一個有效的任務分配機制,確保每個節點都能夠均衡地進行工作。

實際案例:分布式爬蟲如何助力企業?

許多企業已經開始利用分布式爬蟲來提升業務效率。例如,一些電商平台透過分布式爬蟲擷取競爭對手的產品信息,分析市場趨勢,從而制定更具競爭力的市場策略。

常見問題

分布式爬蟲是否會對網站造成負擔?

會的,如果沒有設計好爬蟲的頻率和規模,可能會對目標網站造成過大的負擔,甚至被封鎖。建議合乎倫理地設計爬蟲,避免對網站造成影響。

設計分布式爬蟲需要什麼前置知識?

你需要具備基本的Python編程能力,了解網路協議(如HTTP),以及對分布式系統的基本認識。

如何確保爬蟲擷取的數據準確性?

可以透過設計資料驗證和清理機制,以確保擷取到的數據準確無誤。此外,使用可靠的數據來源也是非常重要的。

哪些Python套件對爬蟲有幫助?

Scrapy、BeautifulSoup、Selenium、Pandas、Numpy等都是非常有用的套件。

結論

設計一個高效能的Python爬蟲軟體架構需要綜合考量多方面的因素,從技術實現到倫理考量,每個步驟都至關重要。掌握這些技巧後,你將能夠更自信地面對數據擷取的挑戰,成為數位世界中的超級英雄!